Cara Kerja Search Engine

Pernahkah Anda merasa penasaran dan bertanya-tanya tentang cara kerja search engine? Saya pernah, sering. Saat pertama kali mengenal istilah-istilah SEO dan mendengar “Google Spider”, saya kerap membayangkan bahwa browser adalah sebuah dunia virtual berisi robot laba-laba dan Google Search adalah Gorgom seperti di film Power Rangers.

Ketika kita mencari sesuatu di internet, robot-robot itu akan berlarian sambil membawa keranjang (kenapa harus keranjang sih, Chan?) untuk mencarikan informasi yang kita butuhkan. Setelah ditemukan, informasi tersebut lalu ditampilkan di depan layar oleh mereka agar bisa kita pilih dan kita baca.

Anda mungkin akan tertawa membaca imajinasi kekanak-kanakan saya itu. Tapi memang begitulah cara search engine bekerja. Well, tidak tepat seperti itu sih, agak mirip lah.

Google Spider, si Robot Laba-Laba

Internet adalah semesta jaringan maha luas. Saking luasnya, kita tidak pernah tahu informasi macam apa saja yang ada di dalamnya. Ada berapa banyak informasi di dalam sana? Jumlah informasi dan data dalam internet sepertinya hanya cocok dinyatakan dengan simbol infinity stone (∞) alias tak terhingga.

Meskipun diciptakan dan dikembangkan oleh manusia, kita tidak bisa masuk ke dalam jaringan dan otak kita pun tidak akan sanggup memproses semua datanya. Maka diciptakanlah robot-robot yang bisa bekerja untuk kita. Salah satunya Google Spider atau Googlebot.

Di titik ini, mungkin Anda mulai berpikir bahwa Google Spider benar-benar berbentuk robot laba-laba seperti di film Transformers (atau ini pikiran saya saja?). Sayangnya Anda harus kecewa karena Google Spider “hanyalah” robot software atau perangkat lunak. Robot-robot software di dalam jaringan sering juga disebut web bots atau bots saja. Sebagai perangkat lunak, mereka tidak punya bentuk fisik.

Tugasnya adalah merayapi atau menelusuri jaringan atas perintah Gorgom Google Search. Karena cara kerjanya yang merayap-rayap di atas jaring dan mirip laba-laba itulah, bot ini disebut “spider”.

Googlebot banyak jenisnya. Ada yang khusus untuk artikel, untuk gambar, untuk mobile phone. Macam-macam.

Selain bot-nya Google, mesin pencari lain seperti Yandex, Bing, dan DuckDuckGo juga punya robot sendiri. Ada juga robot-robot milik SEO tool seperti milik Ahrefs, Moz (dobot), Semrush, dan lain-lain.

Karena bot diciptakan oleh manusia yang notabene ada setan-setannya, tidak semua bot diciptakan sebagai tokoh protagonis. Banyak di antaranya yang dibuat untuk meretas, difungsikan sebagai malware, mencuri data, dan sebagainya.

Ada berapa banyak bot di dalam internet? Ya mana saya tahu. *dicabok

Tapi kalau Anda penasaran, 90% pengunjung web kita bukanlah manusia melainkan bot-bot itu.

Beginilah Cara Kerja Search Engine, Nomor 3 Akan Membuat Anda Tercengang

Google Search, search engine terbesar di Bumi saat ini, sebetulnya punya mekanisme sederhana. Yang rumit hanya algoritmanya.

So, beginilah cara kerja search engine:

1. Crawling

Ini bukan judul lagu Linkin Park. FYI aja.

Pertama-tama, Google Spider, si robot laba-laba kita, berkeliaran di dalam jaringan dan mulai menelusuri setiap web yang ada. Spider datang ke web tersebut (sambil membawa keranjang), mencari tahu tentang isinya, dan memasukkannya ke dalam daftar known pages. Kegiatan atau proses ini disebut crawling.

Tapi dari mana mereka tahu jika ada web baru? Dari mana mereka tahu kalau misalnya kita menerbitkan artikel baru? Apakah mereka tahu ke mana arah yang harus dituju atau begitu saja mengikuti aliran angin? (Euh, mulai ngaco)

Dalam halaman resminya Google mengatakan bahwa tidak ada pusat data untuk itu dalam artian pada awalnya mereka TIDAK TAHU. Mereka tahu ada halaman baru dari:

- Dari link yang ada di known pages. Saat mengunjungi known pages dan mendapati link, crawler akan mengikuti link tersebut.

- Jika si pemilik website memberi tahu Google. Misalnya, melalui sitemap atau mengajukan langsung artikel untuk diindeks melalui Google Search Console.

- Dari link di website lain. Sering juga disebut backlink.

Seberapa sering Google Spider datang ke web kita? Robot-robot itu diprogram untuk mengunjungi halaman-halaman web berdasarkan rentang waktu tertentu agar web kita tidak overload. Selain itu, bot mesin pencari tidak akan melakukan crawling dan indexing jika kita melarangnya. Misalnya, jika kita melakukan de-index atau melarang bot tertentu di robots.txt.

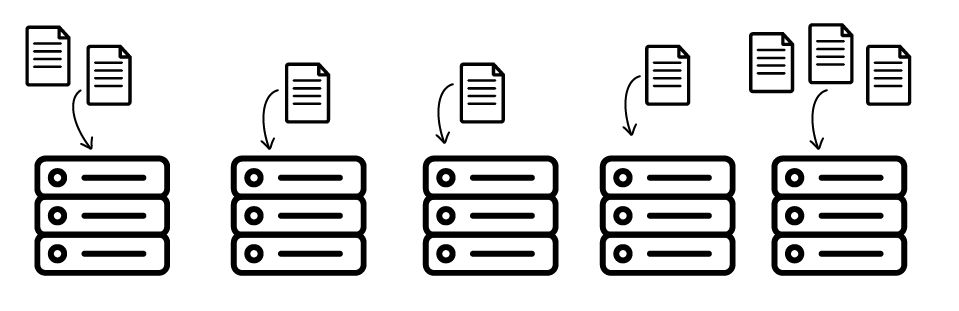

2. Indexing

Setelah menemukan web-web baru termasuk semua halaman di dalamnya, Google Spider kembali ke markas besar a.k.a Google Index. Sekarang coba bayangkan ruang arsip maha besar berisi banyak sekali lemari kabinet dengan laci-laci di dalamnya.

Di sana, semua informasi itu dipilah dan dipilih. Setiap elemen web kita dikategorikan dan dibuatkan katalog. Kemudian, setelah spider cukup mengerti isinya, data setiap web dimasukkan ke dalam lacinya masing-masing.

Proses ini disebut indexing.

3. Ranking

Ini proses yang paling menentukan.

Saat kita browsing atau melakukan pencarian menggunakan Google Search dan memasukkan query di search bar, secara tidak langsung kita memerintahkan, “Hey Google, tolong carikan saya informasi anu.”

Google Search akan mencari ke dalam laci-laci. Karena ada miliaran laci, jelas tidak mungkin menampilkan seluruh isinya. Maka Google memilihkan beberapa informasi paling relevan dan mengurutkannya dari yang paling sesuai sampai yang gak penting-penting amat. Proses pengurutan ini disebut ranking.

4. Serving

Setelah memilih dan mengurutkan, Google akan memberikan sebuah daftar dan menampilkannya di layar browser kita. Ini disebut serving.

Berdasarkan daftar itu, kita bisa memilih untuk menuju dan membaca web yang mana. Daftar berisi hasil pencarian sering disebut juga dengan search results (SERPs).

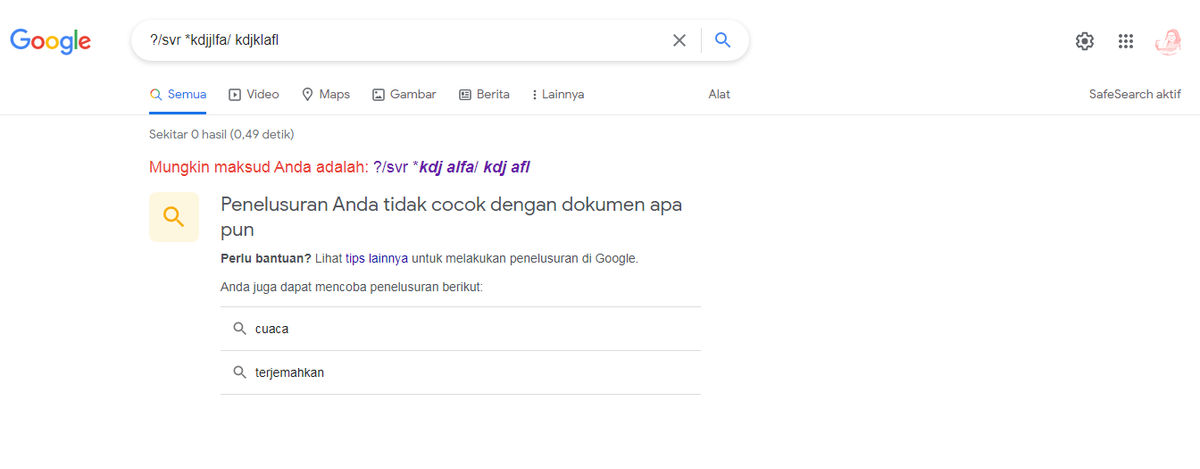

Bagaimana bila tidak ada document yang sesuai? Hal tersebut jarang sekali terjadi, tapi jika itu terjadi, Google akan memberi tahu bahwa tidak ada document di dalam data mereka seperti ini:

Google Algorithm and Ranking Factors

Mungkin Anda bertanya-tanya, di antara miliaran laci yang ada di dalam Google Index, bagaimana mereka memutuskan untuk memilih laci yang mana setiap kali kita melakukan pencarian? Mereka memakai algoritma, dikenal juga dengan sebutan Google algorithm.

Algoritma dalam bahasa pemrograman adalah urutan langkah logis yang digunakan untuk menyelesaikan suatu masalah. Kaitannya dengan Google Search, algoritma digunakan untuk mempertimbangkan saat memilih laci-laci dalam indeks. Ada lebih dari 200 poin pertimbangan yang dipakai, poin-poin ini disebut ranking factors.

Tapi kita tidak akan membahas algoritma dan ranking factors lebih jauh karena bahasannya panjang sekali. Mungkin nanti, di artikel lain.

Mekanisme atau cara kerja mesin pencari lain seperti Yandex, Bing, DuckDuckGo, atau Brave Search kurang lebih sama. Yang sedikit berbeda mungkin algoritma dan ranking factors yang mereka tetapkan.

Sekarang, setelah saya tahu cara kerja search engine yang lebih ilmiah, saya tidak lagi penasaran. Sayangnya, entah mengapa bayangan robot laba-laba yang berlarian sambil membawa keranjang itu masih lekat dalam ingatan. Ya biarlah …. (eL)